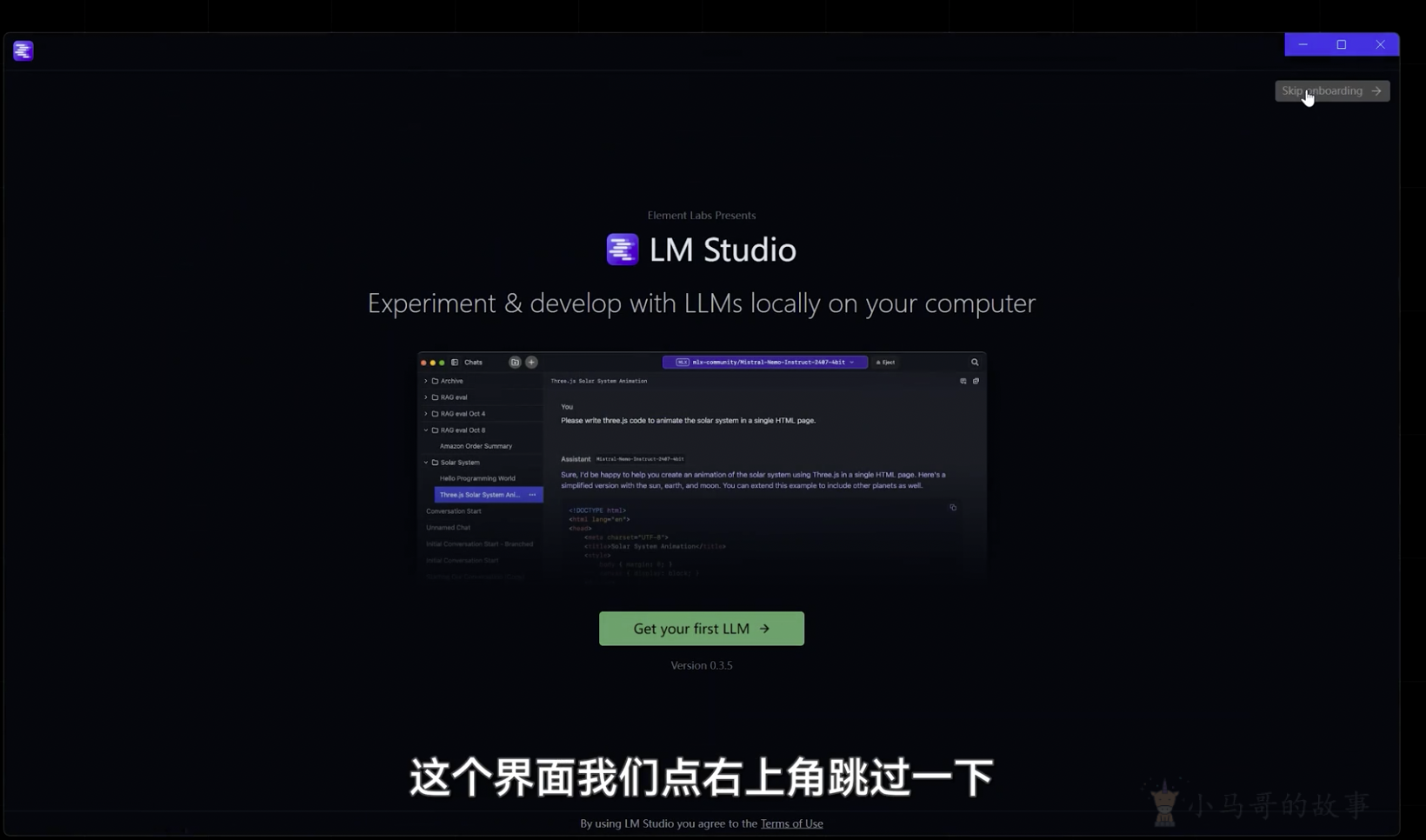

之前分享了 Ollama 这次分享一下 另一款本地运行大模型的工具LM Studio

什么是 LM Studio?

LM Studio 是一款用于在您的电脑上开发和实验LLMs的桌面应用程序。

关键功能

- 桌面应用程序,用于运行本地 LLMs

- 一个熟悉的聊天界面

- 搜索和下载功能(通过 Hugging Face 🤗)

- 一个可以监听类似 OpenAI 端点的本地服务器

- 本地模型和配置管理系统

系统要求

LM Studio 通常支持 Apple Silicon Macs、x64/ARM64 Windows PC 和 x64 Linux PC。

macOS

- 芯片:苹果硅(M1/M2/M3/M4)。

- macOS 13.4 或更高版本是必需的。

- 对于 MLX 模型,需要 macOS 14.0 或更高版本。

- 16GB+内存推荐。

- 您可能仍然可以在 8GB 的 Mac 上使用 LM Studio,但请坚持使用较小型号和适度的上下文大小。

- 英特尔 Mac 目前不支持。

Windows

LM Studio 支持 x64 和 ARM(Snapdragon X Elite)架构的系统。

- CPU:需要支持 AVX2 指令集(针对 x64)

- RAM: LLMs可能会消耗大量 RAM。建议至少 16GB 的 RAM。

Linux

- LM Studio for Linux 以 AppImage 的形式分发。

- Ubuntu 20.04 或更高版本是必需的

- 仅支持 x64,暂不支持 aarch64

- Ubuntu 版本高于 22 的版本测试不佳。

- CPU:中央处理器

- LM Studio 默认支持 AVX2

如何安装 LM Studio?

LM Studio 适用于 macOS、Windows 和 Linux。

前往下载页面并下载适用于您的操作系统的安装程序。

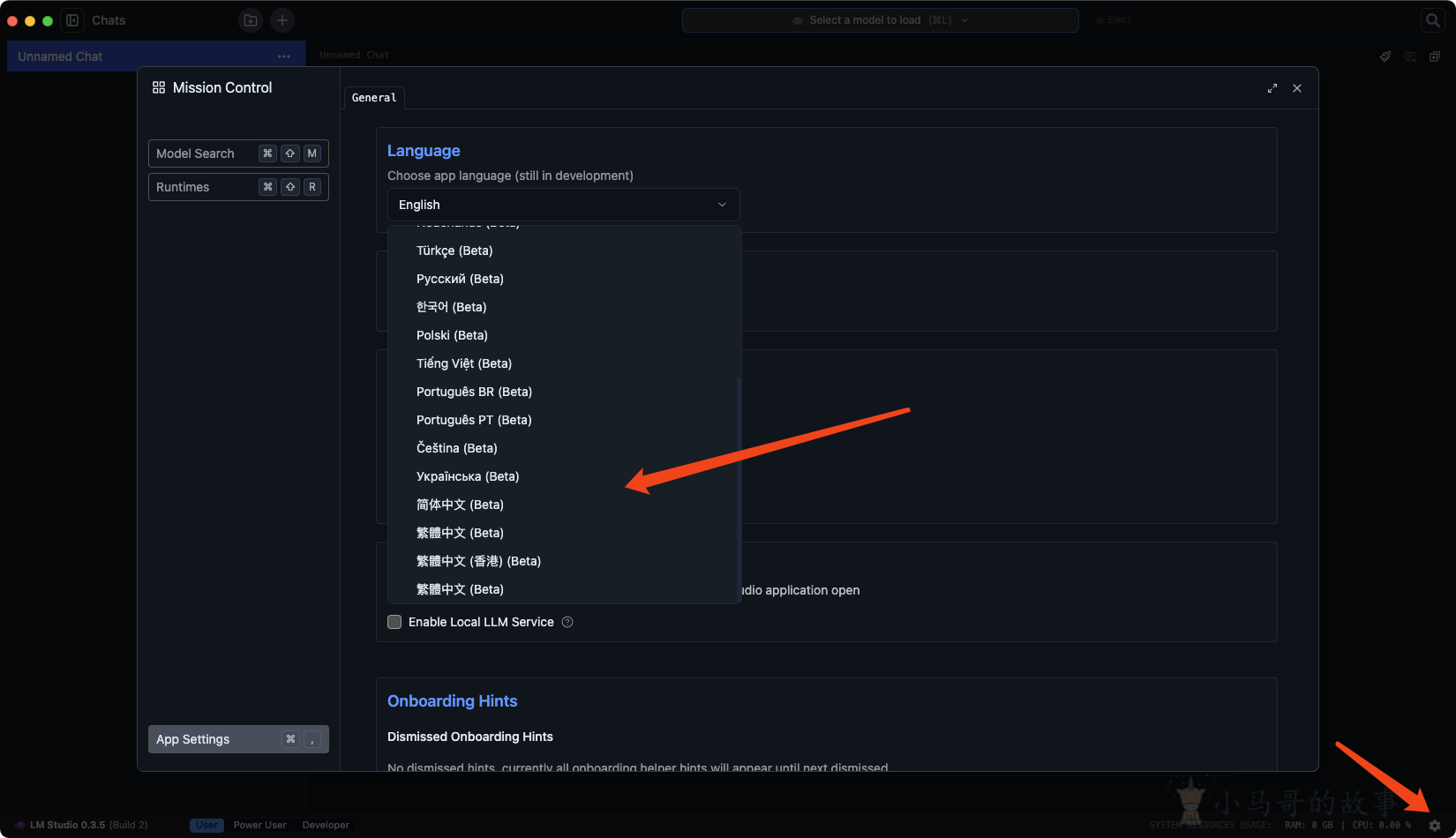

设置中文

右下角设置

设置模型目录

模型目录最好不要有中文特殊符号,最好是英文字母

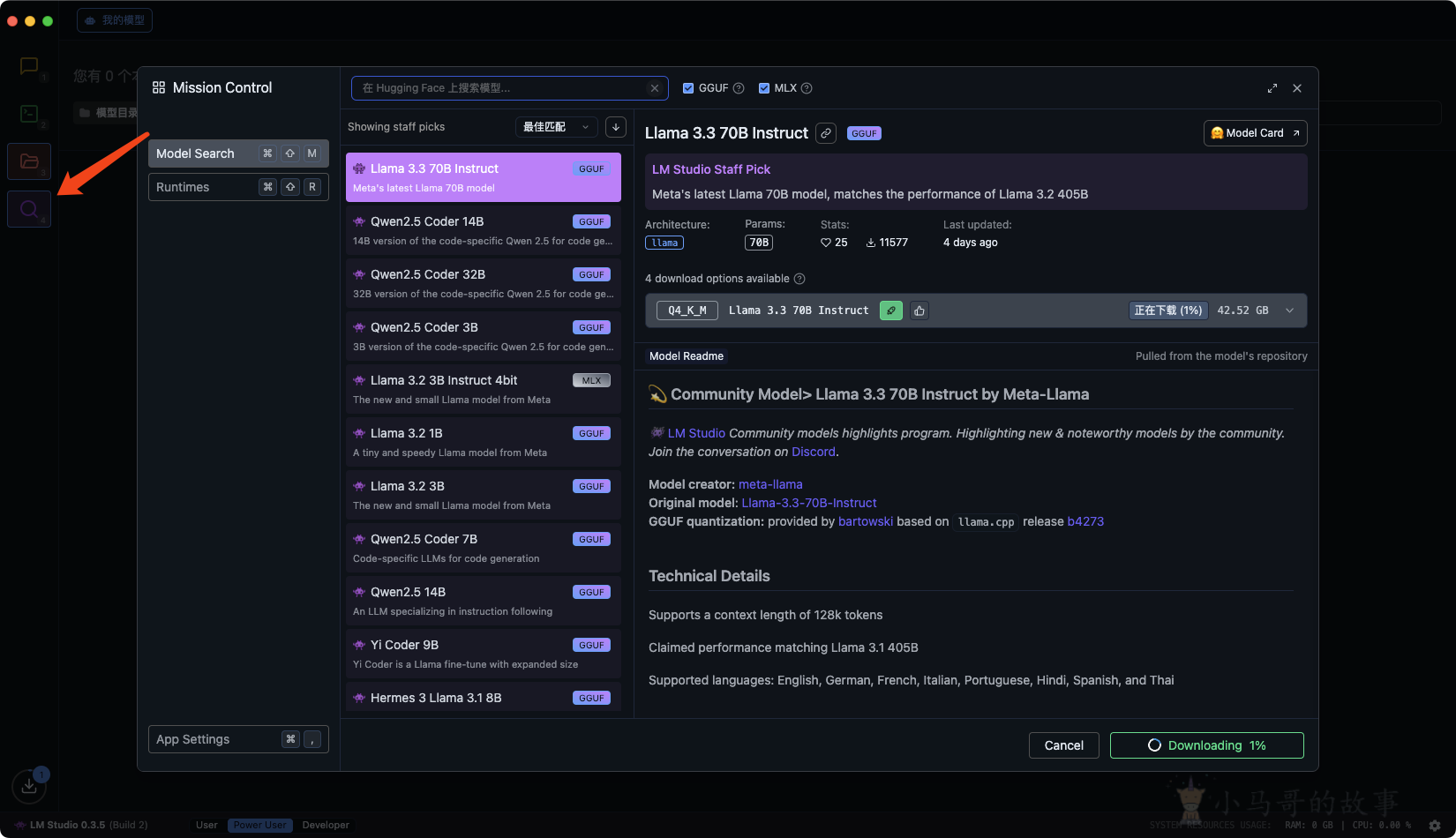

下载模型

如果可以科学上网

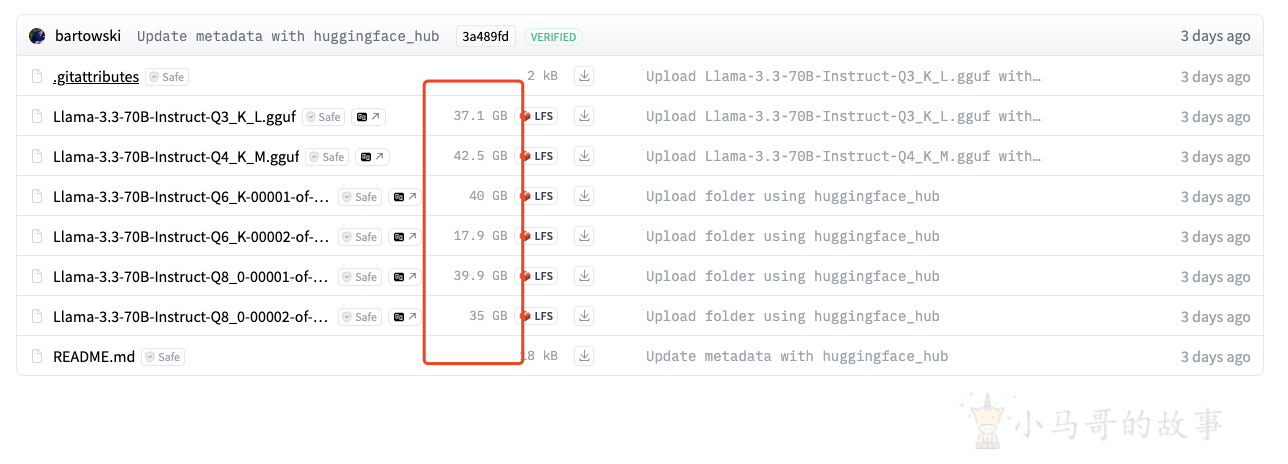

镜像网站下载

https://hf-mirror.com/

下载gguf模型放到前面设置的模型目录里面

模型挑选

模型文件大小小于自己显存大小,但接近显存大小的效果肯定越好

GGUF模型

GGUF,全称 GPT-Generated Unified Format,是一种新型的文件格式专门用于存储和交换大型机器学习模型的数据。这种格式针对模型的快速加载和保存进行了优化,使其在推理方面更加高效。GGUF可以有多重不同版本的量化,Q2、Q3、Q4、Q5、Q6、Q8,这些数字表示模型权重的位数,位数越高,模型的精度通常越高,但所需的存储空间和计算资源也越多。

不是所有 gguf 格式的模都能用 LM Studio 运行,你可以打开下面这个链接,这里所有模型都可以用LM Studio 运行:https://hf-mirror.com/lmstudio-community *量化是指将模型中的高精度数字转换为低精度数字,以减少模型的存储空间和计算需求。

本文由 小马哥 创作,采用 知识共享署名4.0 国际许可协议进行许可

本站文章除注明转载/出处外,均为本站原创或翻译,转载前请务必署名

最后编辑时间为:

2024/12/10 02:44